Robôs Que Sentem Emoções: A Revolução da Inteligência Artificial

Você verá como sensores emocionais — voz, rosto e biosinais — captam reações; como a AI emocional aprende e decide respostas; e aplicações reais em saúde e educação que podem apoiar seu dia a dia.

Também abordamos ética, privacidade e limites técnicos, e mostramos como você pode se proteger e participar desse futuro. Robôs com emoções já são realidade — e essa tendência está mudando a forma como máquinas e pessoas se relacionam.

Principais aprendizados

- Você pode se conectar a robots empáticos.

- Robôs emocionais transformam saúde e atendimento.

- Riscos éticos e de privacidade exigem regras claras.

- Transparência e responsabilidade são fundamentais.

Como funcionam os robôs que sentem: sensores e modelos de emoção

Um robô que sente começa coletando sinais e termina agindo com base em modelos que traduzem esses sinais em intenções úteis. Pense nele como um assistente atento: escuta, observa e mede para entender seu estado. Laboratório de Computação Afetiva do MIT

Fluxo básico:

- O sensor capta o sinal.

- O sinal vira dados digitais.

- Os dados alimentam modelos de interpretação.

Nota: a privacidade é central — sempre questione como seus dados são gravados, armazenados e usados.

Sensores emocionais: voz, rosto e biosinais

Os principais canais são:

- Voz: tom, ritmo, volume, pausas — processados por técnicas de voice recognition.

- Rosto: expressões e microexpressões analisadas por visão computacional.

- Biosinais: batimentos, condutância da pele, temperatura — integrados em aplicações médicas e de monitoramento, como discutido em IA na medicina.

- Toque e postura: proximidade, pressão, movimentos do corpo.

IA emocional e aprendizagem afetiva

A IA emocional aprende padrões a partir desses sinais:

- Extração de características: converter som e imagem em vetores numéricos usando técnicas de deep learning e neural networks.

- Fusão multimodal: combinar voz, vídeo e biosinais para maior precisão, tema presente em pesquisas sobre aplicações multimodais.

- Modelos: neural networks, modelos probabilísticos e árvores de decisão (veja também conceitos em machine learning).

- Personalização: ajustar interpretações ao seu estilo individual, como em assistentes que utilizam técnicas de AI in virtual assistants.

Pipeline resumido:

- Recebe dados multimodais → pondera cada source → produz interpretação (alegria, estresse, etc.) → ajusta com feedback do usuário. Veja uma Revisão sobre aprendizagem multimodal e emoções.

Como respondem os sistemas

As respostas são definidas por regras e aprendizado:

- Mapear emoção → objetivo (confortar, alertar, ajustar).

- Priorizar security e consentimento, seguindo princípios de ética em IA.

- Ajustar intervenção: sugestão, pergunta, ação prática em escala, similar ao que se vê em aplicações reais do uso da IA no mundo real.

Lembrete: respostas empáticas não substituem ajuda humana em crises; robôs podem sinalizar e encaminhar para profissionais.

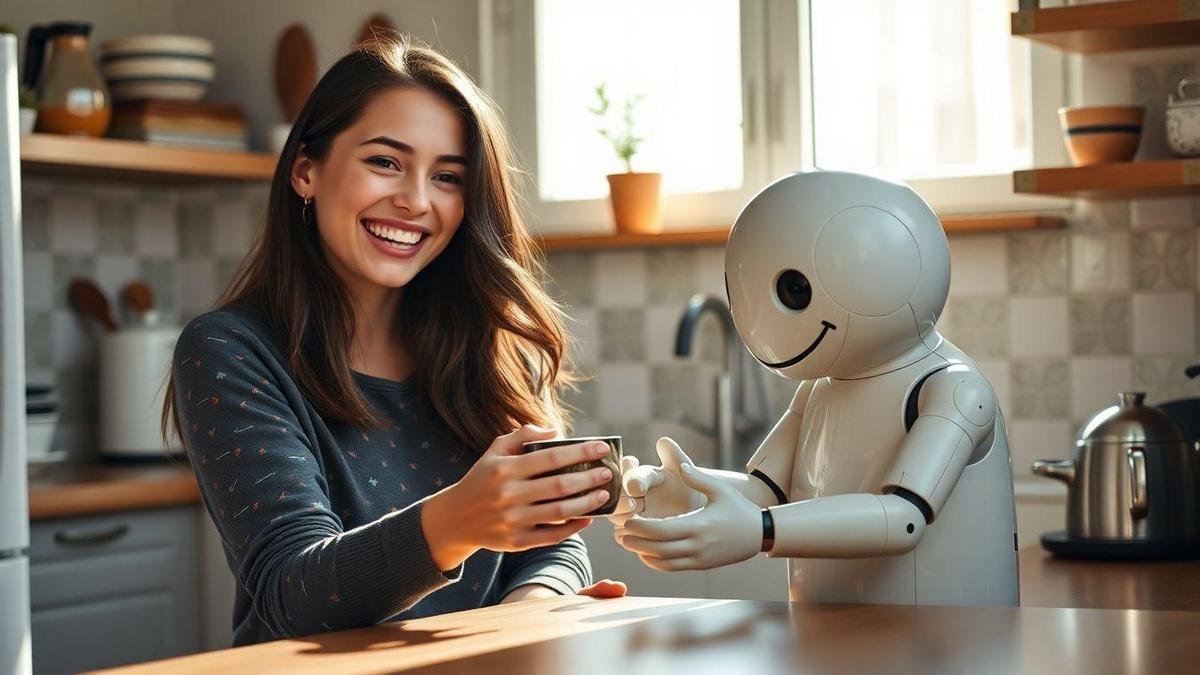

Aplicações reais de Robôs que sentem: da saúde à educação

Robotics e IA emocional já têm casos de uso práticos que beneficiam pacientes, alunos e cuidadores.

Robótica afetiva em hospitais

- Apoio emocional: conversas, músicas, companhia para reduzir solidão.

- Monitoramento: detecção de variações vitais e de humor, alertando equipe, com benefícios discutidos em IA na medicina.

- Intervenções simples: lembretes de remédio, exercícios respiratórios e orientações de fisioterapia leve; a robotics médica avança em paralelo com robôs especializados, como em robôs cirurgiões.

Benefícios: redução de ansiedade em idosos e crianças; detecção precoce de quedas; liberar tempo da equipe humana.

Robôs na escola

- Suporte social para alunos tímidos e com dificuldades de interação.

- Adaptação do ensino ao ritmo emocional do aluno, aproveitando experiências em robotica na educação.

- Feedback emocional para reduzir frustração e manter motivação.

Resultados: maior atenção, engajamento e progresso individualizado.

Exemplos práticos

- Idosos: companhia diária, lembretes e alertas de queda.

- Depressão leve: conversas guiadas, exercícios e registro de humor.

- Autismo: treino de habilidades sociais com interações previsíveis.

- Fisioterapia: contagem de repetições e incentivo com feedback emocional.

Aviso: são complementos, não substitutos de profissionais.

Interação humano‑robô e empatia artificial

Empatia artificial permite que máquinas reconheçam sinais e respondam de forma mais natural, tornando interações mais rápidas, menos frustrantes e mais humanas.

Como melhora comunicação e confiança:

- Comunicação clara: repete ou simplifica quando percebe confusão.

- Menos frustração: respostas calibradas reduzem irritação.

- Maior confiança: consistência aumenta a adesão a sugestões.

- Personalização: recorda preferências e adapta comportamento.

Sinais que robôs leem: tom, palavras‑chave, expressões faciais e postura — combinando processamento de voz e linguagem natural, como explorado em natural language processing e em estudos sobre voice recognition. Respostas típicas: suavizar tom, oferecer opções, confirmar entendimento, acender luz ou tocar música calma.

Mudança na relação com máquinas:

- Proximidade e delegação de tarefas emocionais pequenas.

- Novas normas sociais (espera-se cortesia mesmo com máquinas).

- Necessidade de limites: controle e transparência sobre dados, um tema central em debates sobre conviver com a IA.

Atenção: empatia artificial é percepção programada, não sentimento.

Ética da IA emocional e debate sobre consciência artificial

Robôs que sentem trazem questões éticas urgentes. Antes de adotar essas máquinas, é preciso discutir consentimento, privacidade e responsabilidade. Consulte as Orientações éticas da OMS para IA.

Privacidade, consentimento e riscos de manipulação

- Coleta sensível: áudio, expressões e sinais fisiológicos são dados íntimos.

- Consentimento frágil: termos longos geram aceitação sem informação real.

- Manipulação emocional: ajustar mensagens para influenciar comportamento (compras, voto, etc.) é um risco real, apontado em análises de ética e regulamentação.

Efeitos potenciais: anúncios exploratórios, chatbots que prolongam conversas para vender, perfis emocionais usados sem autorização.

Se um sistema tenta alterar seu humor para lucro — recue, documente e exija explicações.

Consciência artificial: limites e responsabilidade legal

Hoje não há evidência de experiências subjetivas em máquinas; elas simulam comportamento. Mesmo assim:

- Limites técnicos: previsão de reações, sem sofrimento ou autoconsciência comprovada (veja discussões sobre cognitive computing e o futuro da IA).

- Riscos práticos: comportamentos automatizados podem causar danos reais.

- Responsabilidade: desenvolvedores e empresas devem responder por vieses, manipulação e danos; práticas de auditoria e correção são discutidas em ética em IA e vieses.

Boas práticas esperáveis:

- Transparência sobre capacidades e limites.

- Correção contínua de vieses.

- Auditorias independentes e mecanismos de reparação.

Como proteger seus direitos diante da IA emocional

Pequenas ações pessoais aumentam sua segurança:

- Reveja permissões de apps e revogue acessos desnecessários.

- Leia resumos de políticas ou use ferramentas que sintetizem termos. Consulte também o Regulamento Geral sobre Proteção de Dados.

- Prefira serviços que explicam claramente o uso de dados emocionais; iniciativas sobre conviver com a IA ajudam a entender boas práticas.

Passos práticos:

- Solicite acesso aos dados coletados sobre você.

- Peça exclusão ou correção quando necessário.

- Documente interações suspeitas (prints, gravações).

- Denuncie a empresas e órgãos reguladores em caso de manipulação.

- Use alternativas offline quando possível.

- Apoie e divulgue leis que protejam dados afetivos.

Dica: pergunte diretamente Como vocês usam minhas emoções? — se a resposta for vaga, considere sair.

Desafios técnicos e limitações

Robôs que sentem enfrentam limitações reais que explicam por que ainda tropeçam ao ler emoções.

Principais problemas:

- Ambiguidade emocional: um mesmo sinal tem múltiplos significados (lágrimas = tristeza ou alívio?).

- Contexto curto: interpretações requerem histórico, não apenas instantes.

- Sinais sutis: microexpressões e nuances muitas vezes escapam.

- Generalização ruim: modelos treinados em um grupo falham em outros — problema conhecido em estudos de neural networks e deep learning.

- Dados enviesados: falta de diversidade cultural e demográfica.

- Falhas dos sensores: ruído, iluminação e distância afetam qualidade, desafios típicos da visão computacional.

Para confiar mais:

- Transparência sobre decisões do sistema.

- Coleta de contexto a longo prazo.

- Diversificar dados de treino por culturas, idades e línguas.

- Sensores e algoritmos mais robustos.

- Revisão humana contínua.

Prioridade: se o objetivo é confiança, comece por transparência e diversidade de dados.

Pesquisa, regulamentação e futuro

Linhas de pesquisa

- Sensores emocionais mais precisos que leem voz, expressão, postura e sinais fisiológicos.

- Modelos multimodais que produzem respostas empáticas alinhadas a contextos.

- Combinação de IA e psicologia para entender intenções e histórico emocional.

- Testes clínicos e estudos em lares e escolas para avaliar benefícios e riscos — alinhado com tendências em tendências de IA para 2025 e reflexões sobre o futuro da IA.

Políticas públicas e normas

Princípios essenciais: privacidade, transparência, segurança e responsabilidade. Medidas recomendadas:

- Regras claras para coleta e armazenamento de dados afetivos.

- Auditorias independentes e relatórios públicos.

- Rotulagem de sistemas que simulam emoções.

- Proibição de usos exploratórios (publicidade dirigida a emoções vulneráveis).

Checklist rápido: consentimento explícito, dados criptografados, auditorias, mecanismos de contestação.

Como se preparar e participar desse futuro tecnológico

- Aprenda o básico: cursos sobre AI, ética e interação humano‑robô.

- Experimente kits e projetos locais de robotics afetiva e veja como a robótica está evoluindo.

- Participe de fóruns, grupos e pesquisas com consentimento ético.

- Leia e questione políticas de privacidade antes de usar um dispositivo afetivo.

- Ensine crianças sobre privacidade emocional.

- Apoie legislação que proteja dados afetivos.

Aja hoje: assine petições por leis de IA responsáveis, participe de pesquisas e faça cursos gratuitos sobre ética em IA.

Conclusion

Robôs que sentem: a nova fronteira da IA! reúne sensores emocionais, IA afetiva e modelos multimodais que tentam ler e responder ao seu mundo interior. São ferramentas poderosas com aplicações úteis em saúde, educação e companhia, mas trazem riscos reais à privacidade, segurança e autonomia.

Exija transparência, consentimento claro e responsabilidade legal. Lembre-se: máquinas simulam empatia; elas não sentem. Use-as como apoio, não substituto, e cobre regras, auditorias e diversidade de dados. Sua voz importa — use-a.

Curioso para seguir o tema? Continue acompanhando atualizações em Tech by Tehub.

Frequently asked questions

Robôs que sentem refere-se a máquinas que reconhecem sinais emocionais e respondem de forma aparentemente empática — uma simulação de sentimento baseada em dados e algoritmos; para fundamentos de IA veja o que é inteligência artificial.

Tornará atendimentos e assistentes mais naturais, com respostas calibradas por tom e contexto, além de suporte em saúde e educação; confira exemplos práticos em AI in virtual assistants e em experiências de robótica na educação.

Não. Elas imitam emoções a partir de padrões; a experiência subjetiva humana ainda não foi demonstrada em máquinas.

Depende. Confiança exige transparência, supervisão humana, proteção de dados e regulamentação adequada — áreas discutidas em ética e políticas públicas.

Alguns já estão em testes; a presença mais ampla depende de avanços técnicos, aceitação social e leis que regulem uso e privacidade — leia relatos sobre robôs em circulação em robôs entre nós.